L’intelligence artificielle (IA) est un domaine en pleine expansion, qui promet de changer le monde de manière significative et profonde. De plus en plus d’entreprises et de gouvernements souhaitent développer leurs capacités en IA pour diverses raisons. Mais comment fonctionne exactement l’intelligence artificielle ?

Dans cet article, nous examinerons de plus près le fonctionnement de l’IA et ses implications pour le monde moderne.

Qu’est-ce que l’IA ?

L’intelligence artificielle (IA) est une technologie qui a le potentiel de changer radicalement la façon dont les humains interagissent avec les machines. En effet, elle permet à ces dernières d’accéder à des capacités cognitives plus avancées et de comprendre leur environnement plus rapidement et plus efficacement qu’avec des méthodes traditionnelles.

Par conséquent, l’IA peut être utilisée pour résoudre des problèmes complexes et fournir des prédictions fiables sur les données fournies. Mais alors, qu’est-ce que l’IA ?

Il s’agit d’un domaine de recherche qui vise à donner aux machines la capacité d’effectuer des tâches qui nécessitent normalement une intelligence humaine. Ces tâches comprennent la prise de décision, le raisonnement logique, l’apprentissage, la planification et le traitement du langage naturel.

Dans le cadre de cette étude, les chercheurs développent des algorithmes complexes qui sont conçus pour mimer le comportement humain et interagir avec son environnement. Ces algorithmes sont ensuite intégrés à un système informatique pour créer une intelligence artificielle autonome capable d’effectuer des tâches sans intervention humaine.

Pour comprendre comment fonctionne l’intelligence artificielle, il est important de comprendre certaines notions clés :

La première est la notion d’algorithme.

Un algorithme est un ensemble de règles ou d’instructions qui définissent comment un ordinateur doit effectuer une tâche spécifique. Les algorithmes sont écrits par les programmeurs afin qu’ils puissent être exécutés par un ordinateur. Une fois qu’un algorithme est mis en place, il peut être appliqué à une variété de données pour générer des résultats précis et fiables.

Un exemple courant d’algorithme est celui utilisé par Google pour indexer les pages Web afin qu’elles soient correctement référencées lorsque vous effectuez une recherche sur Internet.

Une autre notion clé concernant l’intelligence artificielle est l’apprentissage automatique (machine learning).

L’apprentissage automatique (ML) se réfère au processus par lequel un logiciel ou un système informatique apprend à partir de données fournies par un utilisateur ou un système externe. Cela permet aux ordinateurs d’analyser et de classer des données pour prendre des décisions éclairées ou identifier des tendances sur lesquelles se baser pour prendre des décisions futures.

Un exemple courant d’utilisation de ML est le filtrage automatique du spam par les services e-mail modernes ; cela permet aux utilisateurs d’identifier rapidement et efficacement le spam et non le spam sans avoir à analyser manuellement chaque e-mail individuellement.

Enfin, il existe divers types d’intelligence artificielle (AI) qui ont chacun leur propre objectif et application spécifiques.

Quelques exemples incluent l’intelligence artificielle symbolique (IA symbolique), qui se concentre sur la compréhension du langage humain et du raisonnement logique ; l’intelligence artificielle subsymbolique (AI subsymbolique), qui se concentre sur la reconnaissance et la prise en compte des données non structurées ; l’intelligence artificielle statistique (IA statistique), qui se concentre sur l’analyse prédictive basée sur les données ; et l’intelligence artificielle évolutive (IA évolutive), qui se concentre sur l’amélioration continue du logiciel en fonction de ses performances passée et présente.

Chacune de ces techniques est essentielle à la compréhension complète du concept AI et à sa mise en œuvre efficace. En conclusion, pour comprendre comment fonctionne l’intelligence artificielle, il convient de comprendre certains concepts fondamentaux tels que les algorithmes, l’apprentissage automatique et divers types d’intelligence artificielle.

Ces outils permettent aux ordinateurs d’interagir avec leur environnement pour prendre des décisions éclairées sans intervention humaine directe. En intégrant cette technologie à votre entreprise, vous pouvez bénéficier d’une meilleure efficacité opérationnelle, accroître la productivité et améliorer votre rentabilité globale.

Comment fonctionne l’IA ?

L’intelligence artificielle (IA) est un domaine qui a connu une croissance exponentielle ces dernières années. Il s’agit d’un domaine très complexe et encore en développement, mais comprendre le fonctionnement de l’IA est essentiel pour comprendre son potentiel et comment elle peut être utilisée.

Afin de comprendre comment l’IA fonctionne, il est important de comprendre ce qu’est l’intelligence artificielle et ce qui la distingue des autres formes d’intelligence.

L’IA est une forme d’intelligence informatique qui peut être appliquée à divers domaines tels que la prise de décision, le traitement du langage naturel ou l’apprentissage automatique. Elle se distingue des autres formes d’intelligence car elle est capable d’apprendre et de s’adapter à des situations données sans nécessiter une intervention humaine.

Une des technologies les plus importantes à la base du développement de l’IA est l’apprentissage automatique. L’apprentissage automatique est une branche de l’intelligence artificielle qui permet aux machines d’apprendre à partir des données qu’elles reçoivent sans avoir besoin d’instructions humaines explicites.

Les systèmes d’apprentissage automatique utilisent des algorithmes pour analyser les données et en tirer des conclusions ou des prédictions sur lesquelles l’ordinateur peut prendre des décisions. Cette technique permet aux ordinateurs d’analyser plus rapidement et plus efficacement les données pour prendre des décisions que les humains ne seraient pas en mesure de faire aussi rapidement ou aussi précisément.

Un autre concept important à la base du fonctionnement de l’IA est le traitement du langage naturel (NLP). Le NLP vise à permettre aux ordinateurs de comprendre le langage humain pour pouvoir communiquer avec les êtres humains.

Les systèmes NLP sont capables d’analyser le texte ou la parole pour en extraire des informations significatives et prendre ensuite des décisions basées sur ces informations. Les systèmes NLP peuvent également être utilisés pour générer du contenu automatisé, ce qui permet aux ordinateurs de créer du contenu pertinent basé sur ce qu’ils ont appris grâce au NLP.

La troisième technologie clé nécessaire au bon fonctionnement de l’IA est le deep learning ou apprentissage profond. Le deep learning est une forme avancée d’apprentissage automatique qui permet aux machines d’accroître leur capacité à apprendre et à se perfectionner par elles-mêmes sans avoir besoin de directives humaines explicites.

Le deep learning repose sur un certain nombre d’algorithmes complexes qui permettent aux machines d’analyser et de traiter les données plus rapidement et plus profondément qu’avec des techniques classiques telles que le machine learning ou l’apprentissage supervisé.

Pour résumer, l’intelligence artificielle (IA) est un domaine très complexe qui repose sur un certain nombre de technologies différentes dont le but est de permettre aux machines d’exprimer une intelligence artificielle comparable à celle des humains.

Le réseau de neurones artificiels

Le réseau de neurones artificiels est un type d’intelligence artificielle qui combine l’utilisation de logiciels et de matériel spécialisé pour mimer le fonctionnement des neurones biologiques. Le réseau de neurones artificiels est basé sur une architecture informatique composite qui tente de reproduire la façon dont les êtres humains traitent les informations.

Les réseaux de neurones artificiels sont constitués d’un ensemble d’algorithmes connectés entre eux qui permettent à la machine d’apprendre et de s’adapter aux données qu’elle reçoit. Chaque algorithme traite un certain type d’information et fonctionne comme un neurone biologique, c’est-à-dire qu’il prend une entrée, calcule une sortie et envoie des informations à d’autres algorithmes, similaires à la façon dont les neurones du système nerveux communiquent entre eux.

Ces réseaux de neurones artificiels sont utilisés pour analyser et traiter des données afin que les machines puissent apprendre et comprendre leur environnement. Ils peuvent être utilisés pour résoudre des problèmes complexes, comme reconnaître des images ou prédire des événements futurs. Ces réseaux peuvent même être mis à jour avec de nouvelles informations afin qu’ils soient plus efficaces et précis dans leurs estimations.

Les réseaux de neurones artificiels peuvent être considérés comme un type « supervisé » d’intelligence artificielle.

En effet, ils nécessitent que les données soient « étiquetées » avec des labels prédéfinis afin que le système puisse apprendre à reconnaître des caractéristiques spécifiques et fournir ensuite des prédictions plus précises. De plus, ces systèmes peuvent être entraînés à reconnaître des modèles dans les données fournies afin qu’ils puissent effectuer une analyse plus approfondie et plus précise des tendances ou comportements présents dans ces données.

Ces réseaux sont également utilisés pour tester divers modèles mathématiques ou statistiques afin de déterminer lesquels offrent les meilleurs résultats et fournir ainsi des solutions optimales aux problèmes rencontrés. Cette technique permet aux entreprises d’utiliser l’intelligence artificielle pour optimiser leurs processus commerciaux, offrir une meilleure expérience client et même améliorer leurs produits existants.

Aujourd’hui, le réseau de neurones artificiels est largement utilisé dans divers domaines, notamment l’analyse financière, la robotique mais aussi la métrologie ou encore la reconnaissance vocale. Les avancées technologiques telles que l’apprentissage automatique ou encore le deep learning ont permis aux réseaux de neurones artificiels d’atteindre une plus grande précision et fiabilité pour exercer leurs fonctions.

Le Machine Learning

Le Machine Learning (apprentissage automatique) est une technologie qui s’appuie sur l’intelligence artificielle et qui peut être utilisée pour résoudre des problèmes complexes. Il s’agit d’une méthode informatique permettant aux ordinateurs de traiter des grandes quantités de données et d’en tirer des conclusions, sans avoir à recevoir explicitement des instructions.

Ainsi, le Machine Learning est un processus d’automatisation du raisonnement et de la prise de décision qui permet aux ordinateurs d’effectuer des tâches sans avoir à être programmés explicitement.

Le Machine Learning se compose de plusieurs méthodes qui permettent aux ordinateurs d’analyser les données, de les organiser et de prendre des décisions basées sur ce qu’ils ont appris. Ces méthodes peuvent être divisées en trois catégories principales : l’apprentissage supervisé, l’apprentissage non supervisé et l’apprentissage par renforcement.

- L’apprentissage supervisé est utilisé pour apprendre à partir de données pré-étiquetées et se focalise sur la prédiction des sorties possibles à partir d’un jeu de données d’entrée. Les algorithmes d’apprentissage supervisé sont principalement basés sur le modèle « entraîner-tester » où l’ordinateur est entraîné sur un jeu de données et ensuite testé pour voir s’il peut reconnaître les sorties correctes. Les algorithmes les plus couramment utilisés comprennent: les réseaux neuronaux, les forêts aléatoires, le k-nn (k-plus proche voisin) et la régression linéaire.

- L’apprentissage non supervisé est utilisé pour trouver des modèles cachés derrière des jeux de données non étiquetés. Cette méthode est souvent utilisée pour rassembler des informations sur un certain nombre de points similaires afin de les classer en groupes distincts. Les algorithmes non supervisés les plus couramment utilisés incluent l’analyse en composantes principales (ACP), la classification ascendante hiérarchique (CAH) et la classification k-means.

- Enfin, l’apprentissage par renforcement est une mise en œuvre directe du concept de renforcement par lequel un agent interagit avec son environnement pour maximiser un indicateur spécifique, tel que la récompense ou le bénéfice. Dans ce type d’environnement, l’agent apprend par essais et erreurs comment optimiser ses performances à mesure qu’il interagit avec son environnement en prenant des décisions basées sur ses observations passée et présente.

Les algorithmes d’apprentissage par renforcement les plus couramment utilisés incluent Q-learning, Monte Carlo Tree Search (MCTS) et Deep Reinforcement Learning (DRL). Ainsi, le Machine Learning repose sur l’utilisation des algorithmes pour analyser les données afin de générer des informations utiles pour prendre des décisions stratégiques. Il permet aux ordinateurs d’acquérir une compréhension plus approfondie du comportement humain et offre une solution rentable pour résoudre divers types de problèmes complexes.

La fiabilité de l’IA

La fiabilité de l’intelligence artificielle (IA) est l’un des aspects les plus importants à considérer lorsqu’on examine comment elle fonctionne. L’IA est conçue pour effectuer des tâches complexes sans intervention humaine, et la fiabilité est essentielle pour garantir que ces tâches sont effectuées avec précision et efficacité.

La fiabilité de l’IA se base sur la qualité des algorithmes et des données qui alimentent le système. Lorsque les algorithmes sont bien conçus et que les données sont complètes, précises et à jour, l’IA peut fonctionner en toute confiance.

Les algorithmes doivent être capables d’apprendre et de s’adapter aux nouvelles données afin de rester pertinentes et fiables. Les données doivent être collectées avec soin afin d’être représentatives des informations qu’elles représentent et d’être suffisamment précises pour fournir une analyse cohérente et précise des informations.

Les tests sont également essentiels à la fiabilité de l’IA.

Des tests intenses doivent être effectués avant que le système ne soit mis en production afin de garantir sa précision et sa fiabilité. Ces tests permettent aux concepteurs d’observer les performances du système en temps réel et d’identifier les domaines où il y a des lacunes ou des points à améliorer.

Cela peut inclure des tests de charge pour vérifier la stabilité du système, ainsi que des tests de performance pour s’assurer qu’il fonctionne correctement dans différents contextes. Les outils tels que les métriques, les mesures d’erreur et les indicateurs clés de performance (KPIs) peuvent également être utilisés pour évaluer la fiabilité d’une IA.

Ces outils peuvent être intégrés au système afin de surveiller constamment son fonctionnement et d’identifier rapidement les problèmes potentiels avant qu’ils ne deviennent critiques. Enfin, la communauté scientifique contribue également à assurer la fiabilité de l’IA en développant constamment de nouveaux algorithmes, outils et technologies pour améliorer le rendement du système. Les chercheurs travaillent en collaboration avec les concepteurs afin de créer des moyens toujours plus efficaces d’utiliser l’intelligence artificielle pour résoudre des problèmes complexes et produire des résultats plus précis.

En somme, la fiabilité de l’intelligence artificielle est une composante essentielle pour garantir que celle-ci fonctionne correctement et fournit des résultats cohérents. Cela nécessite une conception rigoureuse des algorithmes, une collecte minutieuse des données, un test intensif du système ainsi que le soutien continu de la communauté scientifique pour garantir sa prétention à long terme.

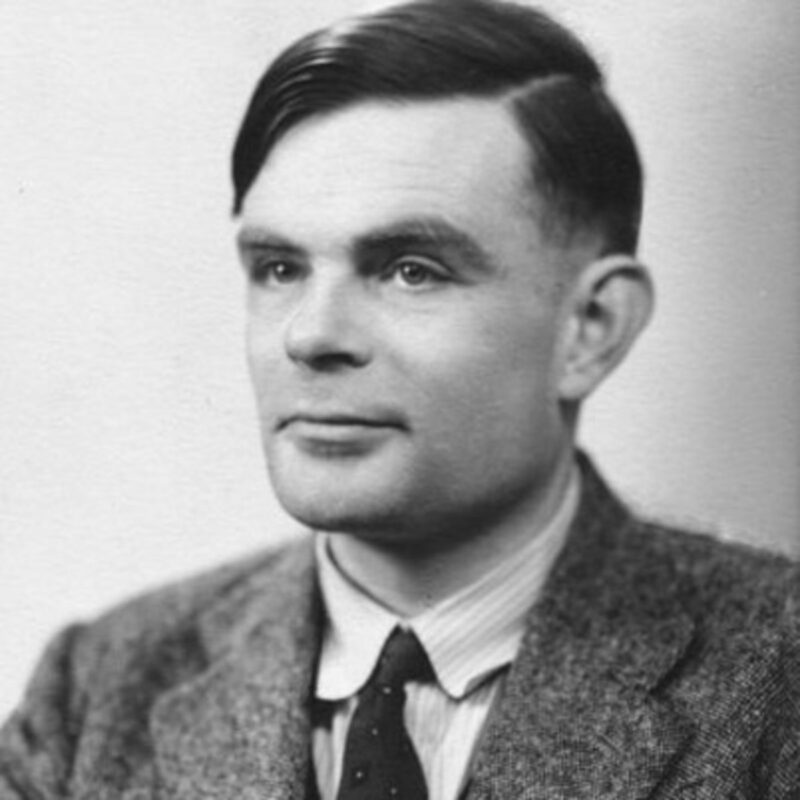

Le test de Turing, clé pour évaluer l’intelligence artificielle

Le test de Turing est une méthode qui permet d’évaluer le niveau d’intelligence artificielle (IA) d’une machine. Cet outil a été inventé par Alan Turing, un mathématicien britannique, en 1950. Dans le but d’analyser la capacité des machines à raisonner et à prendre des décisions similaires à celles des humains, le test de Turing est devenu le point de référence pour évaluer l’intelligence artificielle.

L’objectif principal du test de Turing est de déterminer si une machine est intelligente ou non. Il s’agit d’un système de dialogue entre un humain et une machine, où les questions se font par écrit, avec l’utilisation d’un ordinateur ou d’une autre sorte de système électronique. Le but est que l’interlocuteur ne puisse pas savoir s’il s’agit d’un humain ou d’une machine à l’autre bout du dialogue.

Si cette tâche est réalisée avec succès, alors la machine peut être considérée comme « intelligente ». Le test de Turing a été conçu pour tester la capacité des machines à imiter le comportement humain et à communiquer comme s’ils étaient humains.

Pour ce faire, il utilise les principes fondamentaux des théories cognitives et neuronales qui sous-tendent le fonctionnement des intelligences artificielles (IA). Les principes clés incluent l’apprentissage profond, la reconnaissance vocale et visuelle, la logique symbolique et probabiliste et la compréhension linguistique. Le test de Turing implique généralement quelques règles spécifiques pour évaluer l’intelligence artificielle. Ces règles peuvent comprendre des questions sur les arts et la culture, l’actualité, les sciences, etc.

Par exemple, une question pourrait être : « Quel est l’auteur de La Lettre volée ? » Une réponse correcte serait : «Edgar Allan Poe». Les questions posées doivent être assez difficiles pour ne pas pouvoir être répondues par un simple algorithme informatique mais suffisamment simples pour ne pas nécessiter une connaissance encyclopédique complète.

Si un ordinateur arrive à convaincre le juge qu’il est capable de penser comme un être humain, alors il aura réussi le test de Turing et sera considéré comme « intelligent ». Si le juge parvient à distinguer la machine du candidat humain, alors le test sera considéré comme échoué. Les résultats obtenus à ce test peuvent ensuite être utilisés pour améliorer l’intelligence artificielle et lui permettre de se rapprocher au maximum du comportement humain.

Le test de Turing est encore largement utilisé aujourd’hui pour évaluer l’intelligence artificielle et sert toujours comme référence essentielle pour mesurer son efficacité. Il permet aux concepteurs d’IA de déterminer si leurs systèmes sont capables d’imiter le comportement humain avec précision et en fournissant des informations précieuses sur la façon dont les machines apprennent ainsi que sur les limites actuelles des IA. De plus, il offre un moyen intéressant d’étudier les effets psychologiques liés aux interactions entre humains et machines intelligentes.

Comment l’intelligence artificielle va-t-elle changer nos vies ?

L’IA est considérée comme l’une des technologies les plus prometteuses de notre époque, et elle est en train de transformer non seulement la façon dont nous vivons et travaillons, mais aussi nos relations avec le monde.

Elle peut aider à améliorer la productivité, à réduire les coûts et à fournir une meilleure prise en charge des clients, et elle a le potentiel de modifier fondamentalement la manière dont nous interagissons avec l’environnement qui nous entoure. Dans cet article, nous examinerons comment l’intelligence artificielle va changer nos vies et comment elle peut être utilisée pour améliorer nos expériences quotidiennes. Tout d’abord, l’IA est un terme générique qui englobe une variété de technologies informatiques et logicielles conçues pour imiter ou reproduire le comportement humain.

Grâce à ces technologies, les ordinateurs sont capables d’analyser et de comprendre des données complexes, ou « apprendre » en fonction des informations qu’ils reçoivent. Les applications de l’intelligence artificielle sont très diverses et se retrouvent dans de nombreux domaines tels que la finance, la médecine et la robotique.

Une autre façon dont l’intelligence artificielle va changer nos vies est qu’elle offre la possibilité d’automatiser certaines tâches quotidiennes qui prenaient du temps et nécessitaient un effort considérable. Par exemple, il est possible d’utiliser des robots pour effectuer des tâches répétitives telles que le nettoyage ou la reconnaissance faciale.

De plus, l’IA peut être utilisée pour analyser des données massives afin de prendre des décisions plus intelligentes et plus rapides. En outre, l’IA est également utilisée pour améliorer la communication entre les personnes. Les chatbots et autres systèmes conversationnels permettent aux entreprises de mieux interagir avec leurs clients et sont capables de fournir une assistance 24 heures sur 24, 7 jours sur 7.

Ces systèmes peuvent également être utilisés pour fournir une assistance personnalisée en répondant aux questions spécifiques des clients. Finalement, l’IA va également modifier notre façon de travailler au quotidien.

Grâce à ce type de technologie, les entreprises peuvent accroître leur productivité en automatisant certaines tâches routinières et en améliorant leur capacité à prendre des décisions basées sur les données disponibles. De plus, les entreprises peuvent tirer parti des avancées technologiques telles que le machine learning (apprentissage automatique) pour améliorer leur efficacité opérationnelle. Ainsi, on voit clairement que l’intelligence artificielle va changer radicalement nos vies à mesure qu’elle se développe davantage.

Elle offrira aux entreprises des outils puissants pour améliorer leurs opérations et augmenter leur productivité tout en réduisant leurs coûts opérationnels. De plus, elle permettra aux individus d’accroître leur efficacité personnelle grâce à un meilleur accès aux informations et aux outils dont ils ont besoin pour réussir dans un monde numérique en constante évolution.

La compréhension de l’intelligence artificielle est un domaine en pleine expansion. Les développements technologiques avancés et les progrès scientifiques font que cette technologie est de plus en plus accessible et utile. Avec l’intelligence artificielle, nous sommes en mesure de résoudre des problèmes complexes plus rapidement et plus efficacement que jamais auparavant. Bien qu’il y ait encore des défis à relever et des progrès à faire, l’intelligence artificielle est en passe de devenir un domaine de recherche incontournable et prometteur.

FAQ

Quelle est la définition de l’intelligence artificielle ?

L’intelligence artificielle (IA) est un domaine de l’informatique visant à créer des programmes et des systèmes informatiques capables d’effectuer des tâches complexes qui, dans le passé, n’auraient pu être accomplies par des ordinateurs. Elle cherche à reproduire les capacités cognitives humaines telles que l’apprentissage, le raisonnement et le traitement du langage.

Comment l’intelligence artificielle est-elle mise en œuvre ?

L’intelligence artificielle peut être mise en œuvre grâce à différents algorithmes et technologies, notamment l’apprentissage automatique, la vision par ordinateur, le traitement du langage naturel et le raisonnement logique. Les programmes informatiques utilisent ces technologies pour reconnaître des modèles dans les données et apprendre à partir des modèles ou prendre des décisions basées sur des critères prédéfinis.

Quel type de tâches peut effectuer une intelligence artificielle ?

Les applications de l’intelligence artificielle sont très variées et peuvent inclure la reconnaissance vocale et faciale, la traduction automatique, les services de conduite autonome, la prise en charge client, la surveillance, l’optimisation des opérations et bien plus encore.

Quelles sont les limites de l’intelligence artificielle ?

Malgré ses avancées technologiques récentes, il y a encore des limites à ce que les systèmes d’IA peuvent accomplir. Par exemple, ils ne sont pas encore capables de résoudre certains problèmes très complexes ou de prendre des décisions complexes basées sur des situations imprévisibles. De plus, ils ne sont pas encore capables de comprendre pleinement le contexte ou la signification plus profonde derrière les données qu’ils analysent.

Quels sont les avantages de l’utilisation de l’intelligence artificielle ?

L’utilisation de l’intelligence artificielle offre aux entreprises un certain nombre d’avantages : elle permet une meilleure prise de décision en raison de son analyse approfondie des données ; elle facilite le traitement rapide et fiable de grandes quantités de données ; elle améliore la productivité et permet une meilleure compréhension et anticipation des besoins clients ; elle augmente également l’efficacité opérationnelle et réduit les coûts.